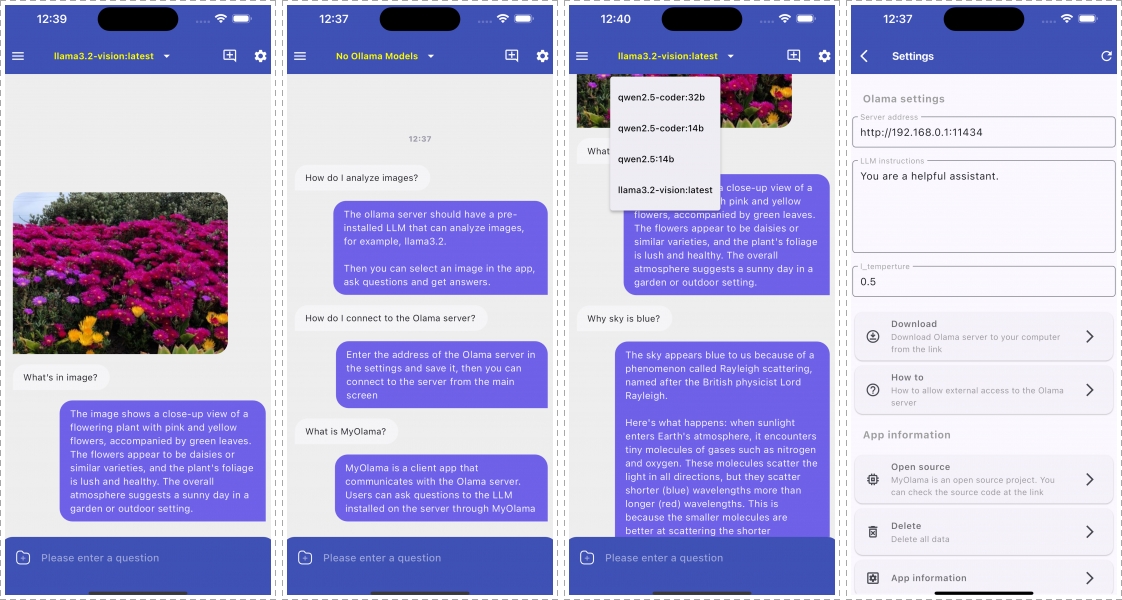

Complete Guide: From Ollama Installation to Mobile App Integration

Overview This technical guide covers the complete process of setting up Ollama, a local LLM server, including external access configuration and mobile app integration using MyOllama. 1. Introduction to Ollama Ollama is an open-source project enabling local execution of various LLMs (Llama, Mistral, Gemma, etc.) on personal computers. It ensures privacy through local execution and