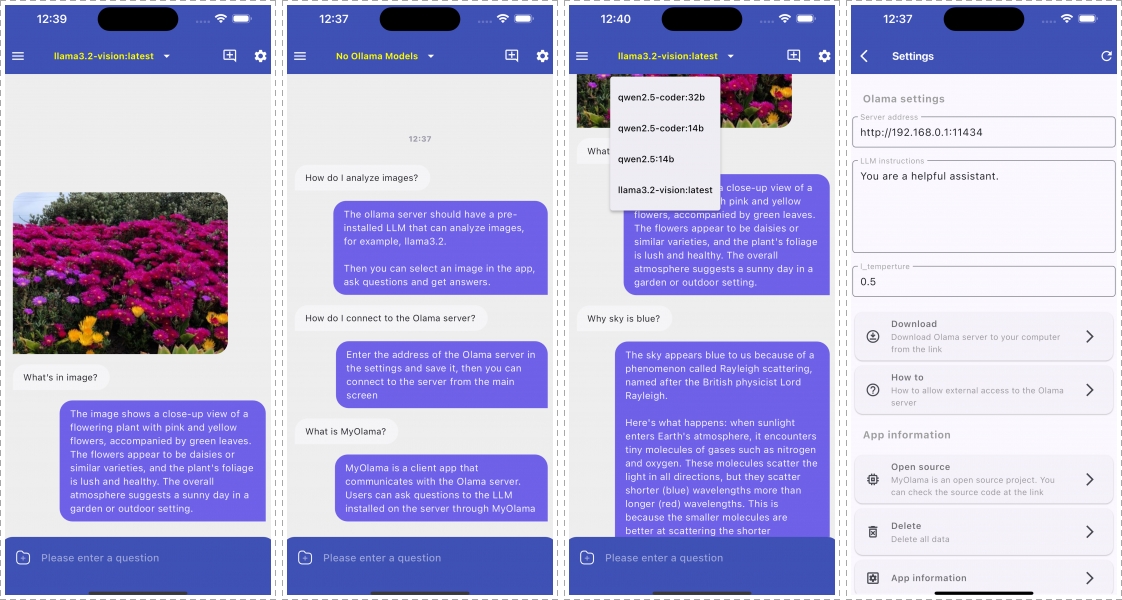

[오픈소스]MyOllama – LLM 모바일 클라이언트

MyOllama는 Ollama가 설치된 컴퓨터에 접속하여 대규모 언어 모델(LLM)과 상호작용할 수 있는 모바일 클라이언트 앱입니다. 소스코드를 다운(https://github.com/bipark/my_ollama_app)받아 빌드 하거나 [애플 앱스토어](https://apps.apple.com/us/app/my-ollama/id6738298481)에서 MyOllama 앱을 다운로드할 수 있습니다. 소개 MyOllama를 사용하면 무료로 다양한 오픈 소스 LLM을 활용할 수 있습니다. Ollama 프로그램을 통해 자신의 컴퓨터에서 LLM을 실행하므로, 별도의 사용료 없이 AI 모델과 대화할 수 있습니다. 주요 기능 – 원격